În ultimii ani, inteligența artificială (IA) a pătruns în aproape toate domeniile vieții moderne: de la birou la școală, din spitale până în sufrageria fiecăruia. Iar odată cu popularizarea asistenților conversaționali precum ChatGPT, Gemini sau Claude, a apărut o nouă tendință: oamenii au început să trateze aceste instrumente ca pe niște terapeuți, medici virtuali sau ghizi de viață. Unii le cer sfaturi despre depresie, alimentație sau relații. Alții își diagnostichează bolile prin conversație cu un algoritm. În teorie, totul pare inofensiv și eficient. În realitate, fenomenul ridică probleme serioase de sănătate, etică și siguranță.

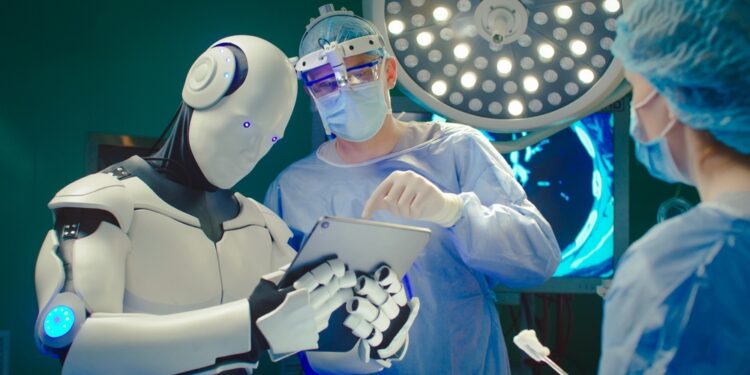

Când algoritmul devine „doctor”

Mulți utilizatori, confruntați cu anxietăți, boli cronice sau stări de confuzie, se îndreaptă spre inteligența artificială pentru un răspuns rapid și lipsit de judecată. Spre deosebire de un medic sau un psiholog, IA e disponibilă 24 de ore din 24, nu cere bani, nu judecă și oferă răspunsuri coerente, structurate, „raționale”. Tocmai această aparență de calm și claritate creează iluzia competenței.

Însă IA nu este conștientă. Ea nu înțelege durerea, contextul sau suferința. Ea procesează informații și le organizează statistic, fără a simți empatie. Oricât de avansată ar fi, inteligența artificială nu are experiență umană, morală sau clinică. Când un algoritm îți spune că „probabil ai anxietate” sau că „ar trebui să bei mai multă apă și să te odihnești”, el nu face un diagnostic medical, ci doar oferă o estimare bazată pe tipare lingvistice extrase din texte de pe internet.

Rezultatul? Milioane de oameni își asumă sfaturi pseudo-medicale care pot fi greșite, incomplete sau chiar periculoase. Există cazuri în care utilizatori au renunțat la tratamente prescrise de specialiști pentru că „IA a zis altceva”.

Dependența de validare digitală

Pe lângă riscul medical direct, apare și o dependență psihologică subtilă. Mulți oameni încep să se bazeze pe IA pentru decizii de viață: dacă să se despartă, ce să mănânce, dacă sunt „buni” sau „răi”, dacă merită o anumită carieră. Algoritmul devine un fel de oglindă idealizată, mereu disponibilă, mereu răspunzătoare.

Această „relație” cu o entitate artificială poate crea detașare de realitate. În loc să vorbească cu prieteni, familie sau profesioniști, unii preferă confortul predictibil al unui text generat. Este o formă de izolare emoțională care poate duce, paradoxal, la amplificarea singurătății — exact opusul scopului aparent: acela de a găsi ajutor.

Psihologii atrag atenția că relația om–IA poate funcționa ca o dependență emoțională. Oamenii ajung să simtă că „doar IA îi înțelege”, iar asta le subminează abilitățile de comunicare și adaptare socială.

Eroarea fundamentală: IA nu este medic

Inteligența artificială nu are pregătire medicală, nu a făcut facultate, nu poate consulta pacienți, nu poate examina, palpa sau interpreta un rezultat de laborator în context clinic. Modelele lingvistice sunt antrenate pe texte, nu pe experiență practică. În unele cazuri, IA oferă răspunsuri plauzibile, dar complet false — fenomen numit „halucinație”.

De exemplu, dacă un utilizator descrie o durere abdominală, IA poate „diagnostica” o simplă indigestie, când de fapt e vorba de o apendicită. Diferența dintre viață și moarte poate fi un singur clic.

Asociațiile medicale din întreaga lume avertizează deja asupra riscurilor: niciun instrument de IA nu trebuie folosit pentru diagnostic, tratament sau recomandări medicale personalizate fără verificarea unui specialist uman.

Pseudoștiința digitală

În mediul online, IA amplifică și răspândește rapid mituri și teorii false. Chiar dacă este programată să evite dezinformarea, IA se bazează pe conținutul existent pe internet — care, la rândul lui, e plin de informații greșite. Astfel, pot apărea sfaturi de tipul „detoxifiere cu sucuri verzi” sau „respirație alcalină” — noțiuni fără fundament științific, dar prezentate într-un ton credibil.

Această pseudo-știință digitală erodează încrederea în medicina reală. Dacă algoritmul pare sigur pe el, iar medicul ezită sau cere analize, unii pacienți ajung să creadă că IA „știe mai bine”.

Efectul de „autoritate artificială”

Inteligența artificială scrie frumos, logic, fără greșeli. Tocmai această perfecțiune lingvistică creează impresia de autoritate. Când un text e coerent, oamenii tind să-l creadă. Dar, în realitate, IA nu are autoritate — doar simulează autoritatea.

Un medic are responsabilitate juridică și etică. IA, în schimb, nu poate fi trasă la răspundere pentru o greșeală. Dacă un sfat eronat duce la agravarea unei boli, vina nu aparține nimănui concret. Răspunderea devine difuză, iar utilizatorul rămâne singurul afectat.

Consecințele pe termen lung

Pe termen lung, folosirea IA ca „doctor” sau „confesor” duce la atrofierea gândirii critice. Oamenii nu mai verifică surse, nu mai pun întrebări, nu mai caută păreri diferite. Acceptă prima variantă „corectă” oferită de o mașină. Aceasta transformă o societate vie, bazată pe dialog și îndoială, într-una pasivă, dependentă de răspunsuri automate.

Mai mult, în domeniul sănătății mintale, folosirea excesivă a IA pentru „terapie” poate duce la autodiagnostic greșit, întărirea tulburărilor și chiar întârzierea tratamentului real. Empatia simulată nu poate înlocui relația umană, în care privirea, vocea și gestul contează la fel de mult ca vorbele.

Cine trage semnalul de alarmă

Organizații precum Organizația Mondială a Sănătății (OMS) și Uniunea Europeană avertizează deja că folosirea IA în domeniul medical trebuie strict reglementată. În paralel, unele platforme de inteligență artificială introduc avertismente clare: „Aceste informații nu înlocuiesc sfatul unui medic.” Totuși, mesajele sunt adesea ignorate.

Profesorii și medicii cer introducerea educației digitale în școli, pentru ca tinerii să învețe diferența dintre o sursă sigură și o simulare convingătoare.