În urma popularizării tehnologiei AI capabile de a crea imagini și videoclipuri din ce în ce mai aproape de cele produse de oameni, OpenAI, Alphabet, Meta, Amazon și mai multe nume importante din domeniul AI au promis, în această vară, să dezvolte tehnologii de filigranare pentru a combate dezinformarea. În august, Google a lansat versiunea beta a unui nou instrument de filigranare, SynthID. În acest fel, compania încearcă să marcheze conținutul AI pe măsură ce este generat.

În mod similar cu incorporarea filigranelor fizice pe bancnote și timbre pentru a dovedi autenticitatea acestora, filigranele digitale au fost create pentru a urmări originea imaginilor și textelor online. Scopul acestor metode este de a ajuta oamenii să identifice videoclipurile create cu ajutorul tehnologiei deepfake și al clonării de voce sau materialele create de roboți, precum cărți.

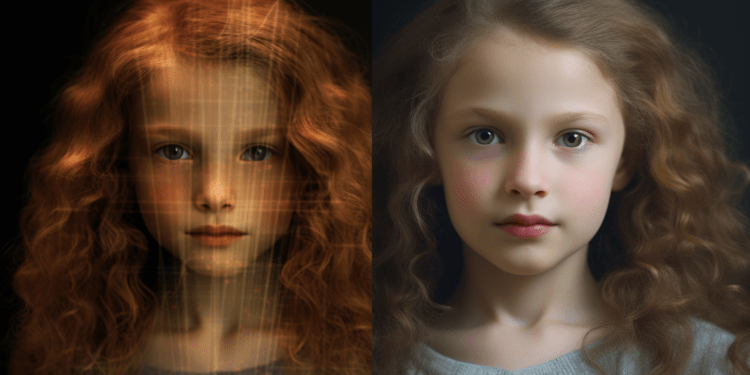

Profesorul de științe computaționale Soheil Feizi și o echipă de colaboratori au analizat cât de ușor încercările de filigranare a conținutului online pot fi evitate, prin ceea ce profesorul numește „ștergerea” filigranului. De asemenea, pe lângă demonstrarea modului în care atacatorii ar putea elimina filigranele, studiul publicat online săptămâna aceasta arată cum adăugarea de filigrane la imagini generate de oameni poate fi făcută, declanșând alarme false.

În luna august, cercetători de la Universitatea California, Santa Barbara și Carnegie Mellon au publicat o altă lucrare care prezintă descoperiri similare, după ce au efectuat propriile atacuri experimentale asupra unor metode de filigranare. Experimentul demonstrează cât de vulnerabile sunt filigranele, în special cele invizibile. Totuși, lucrarea de cercetare a profesorului Feizi merge chiar mai departe. În timp ce unii cercetători au sperat că filigranele vizibile („cu perturbare mare”) ar putea fi dezvoltate pentru a rezista la atacuri, Feizi și colegii săi spun că până și acest tip mai promițător poate fi manipulat. Alții consideră că filigranarea are un loc în detecția AI – atât timp cât înțelegem limitele sale. Unii experți din domeniul detecției AI consideră că îmbunătățirea filigranării și apoi utilizarea sa în combinație cu alte tehnologii va face mai dificilă crearea de falsuri convingătoare.